Les agents IA, pas que de la poudre aux yeux

Veltys Data & IA Veltys StratégieAux origines des agents : des promesses de gains de temps et d’efficacité

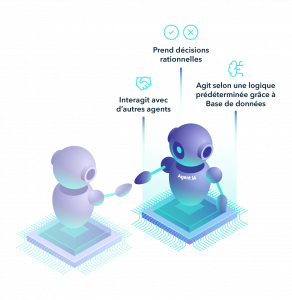

Très vite après la montée en puissance des Large Language Models, on a vu apparaître ou plutôt réapparaître des agents IA. Réapparaître, car l’idée ne date pas d’hier : on trouve la première mention de ce concept dans les travaux d’Herbert Simon (Prix Nobel d’Economie), Alan Newell et John Clifford Shaw en 1959. Si ce terme est utilisé aujourd’hui à tort et à travers, on peut néanmoins se rattacher à la genèse de ces agents pour bien comprendre ce qu’ils sont et ce qu’ils peuvent faire. Né des sciences économiques, un agent se définit premièrement comme un acteur rationnel prenant des décisions dans le but de résoudre ou d’optimiser un problème. Appliqués à la sphère informatique, les agents deviennent des objets capables d’agir selon un ensemble de règles logiques prédéterminées qui vont régir leur capacité à :

- Utiliser les données qui se trouvent dans leur environnement pour prendre une décision informée,

- Interagir avec des systèmes et/ou d’autres agents.

Aussi surprenant que cela puisse paraitre, les agents IA sont prometteurs du fait de ces deux caractéristiques :

- Ils peuvent faire appel à des données internes (celles encapsulées dans le LLM utilisé) mais aussi externes (documents, fichiers, base de données, etc.) en fonction d’un prompt initial

- Ils peuvent choisir d’interagir avec un système comme une application mobile ou un logiciel, ou un outil de visualisation de données, toujours en fonction du prompt.

De là à imaginer des super assistants capables de mimer un comportement humain rationnel, il n’y a qu’un pas.

Mais si la belle promesse des agents est bien réelle et peut être déjà appréciée, c’est qu’ils ont démontré qu’ils peuvent battre les derniers grands modèles de langage et leurs centaines de milliards de paramètres. Sur leur propre terrain. Microsoft a par exemple réussi, avec une suite d’agents, à dépasser de 9 % la précision de ChatGPT 4 dans des examens médicaux. Google a pour sa part démontré qu’un agent faisant 32 appels à son modèle Gemini soutenait la comparaison avec un appel au dernier modèle d’OpenAI.[1]

L’intégration des agents IA dans des processus existants

Dans la mesure où ces agents sont capables d’utiliser des données mais aussi de s’intégrer à des systèmes existants, ils peuvent tout à fait s’intégrer rapidement dans les processus existants au sein d’une organisation.

Prenons l’exemple d’un bureau d’étude dans le secteur immobilier que Veltys a accompagné. Sur une mission d’audit de 20 jours, plus d’un quart est dédié au processus suivant :

- Lire des dizaines de documents hétérogènes (documents notariaux, diagnostics techniques, etc.),

- Extraire les informations pertinentes des documents techniques,

- Vérifier méticuleusement la cohérence des informations,

- Consolider et rédiger un état des lieux des risques pour un bâtiment donné.

Ce processus peut facilement se modéliser avec des agents IA dans la mesure où il n’est question que de faire appel à des données dans une base, puis d’interagir avec un système qui vérifie la cohérence des informations et un autre qui génère un état des lieux en suivant un template donné.

Facteurs clés de succès

Néanmoins, les agents ne sont pas capables de tout. Ils peuvent souffrir des mêmes problématiques que l’on rencontre lorsqu’on se décide à intégrer des modèles d’Intelligence Artificielle non-génératifs :

- Manque de données d’entrainement pour affiner leurs comportements dans les processus

- Trop grande adaptation aux données d’entrainement (overfitting) rendant l’agent incapable de s’adapter à des cas qu’il n’a jamais rencontrés

- Dérives de performances

Aussi est-il bon de rappeler que l’agentique, si elle peut pallier certaines limites des IA génératives, ne les corrige pas toutes. Un agent, comme un LLM, peut :

- être victime d’hallucinations

- être victime de distraction

- produire des résultats qui manquent de cohérence par rapport aux prompts et instructions initiales.

Il faut être d’autant plus vigilant que les risques d’erreurs peuvent être rapidement élevés au carré ou au cube. En effet, les agents enchaînant des suites de tâches dépendantes les unes des autres, si une erreur se glisse dans la première tâche, elle risque de contaminer le reste du raisonnement, voire dans certains cas de masquer l’erreur. Nous avons par exemple rencontré chez Veltys le cas où une analyse statistique très séduisante réalisée par un agent, cachait des données hallucinées à la source du raisonnement.

C’est avec ces limites en tête qu’il faut, à notre sens, se lancer dans une démarche de conception et d’intégration d’agents dans les process.

Chez Veltys, nous avons identifié 3 principaux facteurs de succès d’une telle démarche.

Premièrement, identifier les cas d’usage qui sont à la foi opportuns d’un point de vue métier et 2. faisables d’un point de vue technique. Pour donner de la traction à un agent, il faut qu’il puisse avoir accès à de la donnée lisible machine et l’exploiter. Sans cette donnée, il est impossible de concevoir un agent performant.

Deuxièmement, une démarche progressive est à préférer à une action on/off où l’on créé un agent en chambre pour le mettre à disposition des métiers et ne plus jamais s’en occuper. Le plus pertinent est de commencer par créer des agents baseline, avec des instructions et des données minimales puis d’évaluer très vite ses performances (les résultats sont-ils suffisants ? Quels sont les gains de temps ?) pour ensuite faire évoluer ses paramètres. On pourra alors améliorer, dans l’ordre :

- La qualité des données que l’agent ingère

- Ses instructions

- Les outils qu’il utilise

- (à la marge) Le LLM qu’il utilise comme moteur

Troisièmement, il est essentiel pour donner de la traction aux agents de mesurer en permanence les gains de temps et de productivité qu’ils permettent d’atteindre. Cette mesure sert à la fois de mesure du ROI mais aussi d’indicateur sur la marge d’amélioration de l’agent. Nous estimons que dans le meilleur des cas, un gain de temps de 50 % est rasonnable. En deçà des 50 %, des optimisations sont certainement possibles. Au-delà, l’espérance de gain est suspecte et ne prend certainement pas en compte certaines dépenses de temps cachées.

Parmi les tâches sur lesquelles on peut raisonnablement espérer des gains de 50 %, on trouve :

- La compilation et mise en forme de chiffres clés pour rédiger des éléments de langage : un agent peut parcourir rapidement les publications statistiques officielles (INSEE, ministères…), en extraire les données pertinentes et les formater selon les standards de communication habituels.

- La rédaction d’argumentaires types, notamment juridiques : en s’appuyant sur une base documentaire (jurisprudences, lois, notes manuscrites, etc.), un agent peut générer rapidement de très bons plans avec des éléments synthétiques.

- La veille et synthèse de presse : les agents excellent dans. l’agrégation et la synthèse d’articles sur un sujet donné.

Ces gains de temps sont atteignables si, et seulement si un travail de conception et de maintenance des agents est entrepris dans la durée. Gardons à l’esprit que les agents, comme les données et comme les modèles statistiques demandent à être optimisés, développés et irait-on jusqu’à dire bien élevés ?

Pour aller plus loin, découvrez le livre blanc « L’IA, les yeux dans les yeux ».

Une invitation à garder un œil critique pour faire de l’intelligence artificielle un véritable moteur d’une transition efficace et maîtrisée.

En libre téléchargement ici

[1] https://bair.berkeley.edu/blog/2024/02/18/compound-ai-systems/